在中國,有1700多萬視力障礙者,相當(dāng)于每100人中就有一名視障者,面對大量不安全因素,他們難以獨自跨出家門。

日前,復(fù)旦大學(xué)自然語言處理實驗室(FudanNLP)基于多模態(tài)大模型“復(fù)旦·眸思”(MouSi),為視障者量身打造了“聽見世界”APP,為視障人群提供生活便利和安全保障。

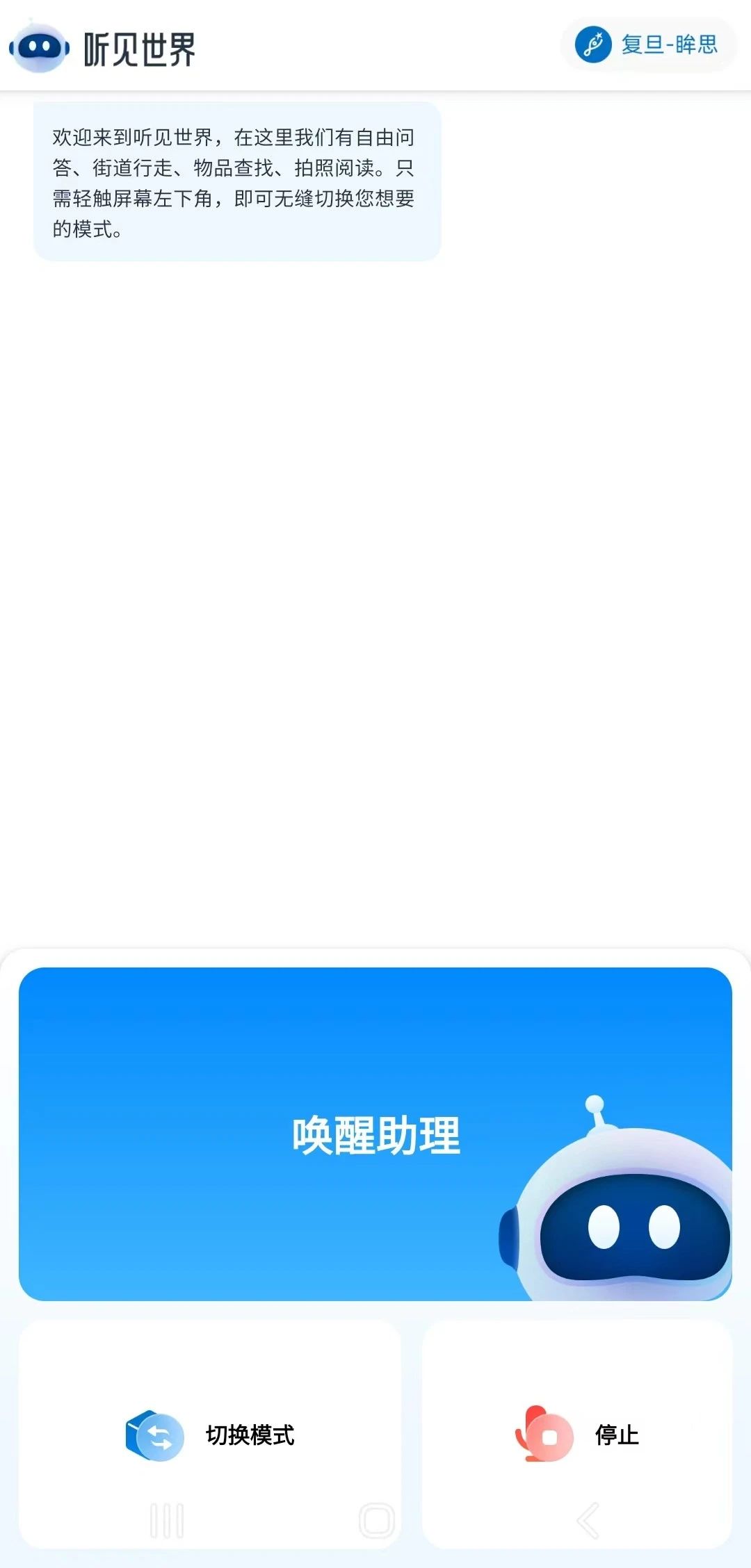

“聽見世界”APP結(jié)合了攝像頭捕捉的畫面和語言轉(zhuǎn)換技術(shù),以描繪場景、識別風(fēng)險并輔助視障者在環(huán)境中安全導(dǎo)航。只需一枚攝像頭和一對耳機(jī),畫面能夠被轉(zhuǎn)化成語言,描繪場景、提示風(fēng)險。(“聽見世界”下載: http://www.mousi.org/)

2023年上半年,復(fù)旦大學(xué)自然語言處理實驗室發(fā)布了開發(fā)MOSS對話式大型語言模型,被稱為中國版的GPT,僅用半年時間多模態(tài)模型“眸思”問世。據(jù)介紹,“眸思”和基于文本的MOSS不同,它能夠理解并識別圖片內(nèi)容,致力于成為視障者的一雙“眸”。

到目前為止,“聽見世界”APP已上線自由問答、街道行走、物品查找、拍照閱讀4種模式。分別是街道行走模式、自由問答模式和物品查找模式。通過街道行走模式,可以細(xì)致掃描道路情況,提示潛在風(fēng)險,如紅綠燈、十字路口、障礙物等。在自由問答模式中,可以描述周圍場景的細(xì)節(jié),用聲音構(gòu)建豐富的生活場景。物品查找模式可以讓視障人士找尋日常物件變得輕松。通過拍照閱讀模式可以將文字轉(zhuǎn)化為語音,服務(wù)點菜、讀書等場景,幫助視障人士獲取更多信息。

項目團(tuán)隊由25名復(fù)旦學(xué)子及多位教師、專家組成。自去年9月以來,復(fù)旦大學(xué)自然語言處理實驗室圍繞GPT4-v復(fù)現(xiàn)多模態(tài)大模型,對核心關(guān)鍵點開展研究,希望提升單項任務(wù)的準(zhǔn)確率和強(qiáng)化大模型的學(xué)習(xí)。為了更好地感受視障者的難處,團(tuán)隊成員模擬真實情境,蒙眼探索視障者“黑暗”世界,并邀請視障人士加入,深入理解視障者的具體需求,收集詳盡的需求信息。

在基于幾億張圖片訓(xùn)練出“眸思”大模型基礎(chǔ)上,針對視障者提出的各類需求,團(tuán)隊又用上萬張圖片進(jìn)行特殊樣本訓(xùn)練,使“眸思”具備能夠適配更多場景的能力。據(jù)透露,今年上半年,團(tuán)隊將結(jié)合AR升級APP內(nèi)的定位精度細(xì)化至亞米級別。下半年,團(tuán)隊希望將“眸思”升級為基于視頻的判斷。據(jù)介紹,更多模式正在開發(fā)中,例如解說模式,可以幫助視障人士解說電影。

據(jù)介紹,團(tuán)隊計劃與NGO組織、智算中心和硬件廠商等開展合作,致力于讓視障者免費使用產(chǎn)品和相關(guān)服務(wù)。預(yù)計今年3月“聽見世界”APP將完成第一輪測試,在一、二線城市和地區(qū)同步開啟試點,根據(jù)算力部署情況進(jìn)行推廣。

注:文章來源于網(wǎng)絡(luò),如有侵權(quán),請聯(lián)系刪除

全部商品分類

全部商品分類